Technology

Czarni założyciele tworzą dostosowane ChatGPT, aby zapewnić bardziej spersonalizowane doświadczenia

Na początku John Pasmore był podekscytowany ChatGPT.

Założyciel serialu był związany ze sztuczną inteligencją co najmniej od 2008 roku. Pamięta czasy, gdy eksperci deklarowali, że upłyną dziesięciolecia, zanim świat ujrzy coś w rodzaju ChatGPT. Przejdźmy dalej – ten dzień właśnie nadszedł.

Ale jest w tym haczyk.

ChatGPT, jedno z najpotężniejszych narzędzi sztucznej inteligencji na świecie, zmaga się z niuansami kulturowymi. To dość denerwujące dla czarnej osoby, takiej jak Pasmore. W rzeczywistości to niedopatrzenie wywołało gniew wielu Czarnych, którzy już nie widzieli siebie odpowiednio reprezentowanych w algorytmach reklamowanych, aby pewnego dnia uratować świat. Obecny ChatGPT oferuje odpowiedzi, które są zbyt ogólne, aby można było odpowiedzieć na konkretne pytania skierowane do określonych społeczności, ponieważ jego szkolenie wydaje się europocentryczne i zachodnie w swoim nastawieniu. Nie jest to niczym wyjątkowym — większość modeli sztucznej inteligencji nie jest tworzona z myślą o osobach kolorowych. Jednak wielu czarnoskórych założycieli stanowczo twierdzi, że nie można pozostać w tyle.

W zeszłym roku pojawiło się wiele chatbotów i wersji ChatGPT należących do osób czarnoskórych, aby zaspokoić potrzeby społeczności czarnoskórych i brązowych, ponieważ twórcy rasy czarnej, tacy jak Pasmore, starają się wykorzystać kulturowe wpadki OpenAI.

„Jeśli ogólnie zapytasz modelkę, kim są jedni z najważniejszych artystów w naszej kulturze, poda ci Leonarda da Vinci i Michała Anioła” – Pasmore powiedział o ChatGPT. „Nie będzie w nim nic napisane o Indiach, Chinach, Afryce ani nawet Afroamerykanach, ponieważ jest nastawiony na europejską trajektorię historii”.

Więc wystartował Pasmore Latimer.AI, model językowy umożliwiający udzielanie odpowiedzi dostosowanych do doświadczeń osób rasy czarnej i brązowej. Zaczęła Erin Reddick CzatBlackGPT, chatbot również skupiony na społecznościach czarnych i brązowych. Na całym świecie ma siedzibę w Kanadzie Świeca, który jest alternatywą dla ChatGPT dla studentów czarnoskórych i brązowych. W Afryce również obserwuje się ogromne innowacje w tej przestrzeni – pojawiają się modele językowe obsługujące ponad 2000 języków i dialektów używanych na kontynencie, które wciąż przeoczają zachodnie modele sztucznej inteligencji.

„Jesteśmy strażnikami naszych własnych historii i doświadczeń” – powiedziała TechCrunch Tamar Huggins, założycielka Spark Plug. „Musimy stworzyć systemy i infrastrukturę, które posiadamy i które kontrolujemy, aby mieć pewność, że nasze dane pozostaną nasze”.

Spersonalizowana sztuczna inteligencja jest już dostępna

Uogólnione modele sztucznej inteligencji nie są w stanie łatwo uchwycić doświadczeń Afroamerykanów, ponieważ wiele aspektów tej kultury nie jest dostępnych w Internecie. Obecne algorytmy przeszukują Internet w poszukiwaniu źródeł informacji, ale wiele tradycji i dialektów w kulturze Afroamerykanów jest przekazywanych ustnie lub z pierwszej ręki, pozostawiając lukę w tym, co model sztucznej inteligencji zrozumie na temat społeczności, w porównaniu z niuansami tego, co faktycznie się dzieje.

Jest to jeden z powodów, dla których Pasmore podczas tworzenia Latimer.AI próbował korzystać ze źródeł takich jak Amsterdam News, jedna z najstarszych czarnoskórych gazet w USA, koncentrując się na dokładności, a nie na szkoleniu na danych generowanych przez użytkowników pobranych z Internetu. Robiąc to, zaczął dostrzegać różnice między swoim modelem a modelem ChatGPT.

Przypomniał sobie, jak ludzie pytali kiedyś ChatGPT o podziemną kolej, czyli przejście, którym zniewoleni czarni Amerykanie podróżowali do północnych stanów, aby uciec przed niewolnictwem. Model ChatGPT wspominałby o zbiegłych niewolnikach, podczas gdy Latimer.AI dostosował sformułowanie, odnosząc się do „zniewolonych” lub „ludzi poszukujących wolności”, co bardziej odpowiada temu, co stało się bardziej społecznie dostosowane podczas omawiania byłych zniewolonych.

„Występują pewne subtelne różnice w języku, którego używa model, ze względu na dane szkoleniowe, a sam model uwzględnia jedynie osoby rasy czarnej i brązowej” – powiedział Pasmore.

Tymczasem ChatBlackGPT Erin Reddick jest wciąż w fazie beta i ma zostać uruchomiony 11 czerwca. Jej produkt działa tak, jak brzmi: chatbot, w którym można zadawać pytania i otrzymywać dostosowane odpowiedzi na temat czarnej kultury. „Sednem tego, co robimy, jest prawdziwie zorientowane na społeczność” – powiedziała.

Jest w trakcie opracowywania narzędzia, pytając użytkowników jak chcą, żeby to wyglądało i jak chcą, żeby działało. Współpracuje także z instytucjami edukacyjnymi, takimi jak historycznie czarne szkoły wyższe i uniwersytety (HBCU), aby współpracować ze studentami zarówno w zakresie nauczania, jak i pomagania w szkoleniu jej algorytmu. Powiedziała, że chce „stworzyć wszechstronne możliwości uczenia się dla osób rasy czarnej i brązowej, aby miały bezpieczną przestrzeń do odkrywania sztucznej inteligencji”.

„Algorytm nadaje priorytet źródłom informacji osób rasy czarnej, dzięki czemu może odnosić się do wiedzy, z którą można się bardziej bezpośrednio utożsamić niż z przeciętnym doświadczeniem” – powiedziała TechCrunch, dodając, że podobnie jak w przypadku produktu Pasmore, technicznie rzecz biorąc, każdy może z niego korzystać.

Tamar Huggins stworzyła świecę zapłonową, aby zapewnić bardziej dostosowane doświadczenia społecznościom czarnoskórym i brązowym. Jej platforma tłumaczy materiały edukacyjne na język afroamerykański wernakularny (AAVE), etnolekt kojarzony ze społecznościami czarnoskórych Amerykanów. Dialekt ten jest tradycyjnie przekazywany ustnie i z pierwszej ręki, a nie studiowany i spisywany jak standardowy angielski, co oznacza dokładność modelu sztucznej inteligencji (lub osoby), która się go uczy po prostu web załamie się w precyzji. Dokładne przechwytywanie AAVE jest ważne nie tylko po to, aby chatbot zareagował, używając go, ale także po to, aby uczniowie mogli łatwiej pisać podpowiedzi, dzięki którym sztuczna inteligencja zwróci potrzebne wyniki.

„Tworząc treści, które przemawiają do czarnoskórych uczniów, zapewniamy, że widzą siebie w edukacji, co ma kluczowe znaczenie dla wysokiego zaangażowania i sukcesu akademickiego” – powiedział Huggins. „Gdy nadarzy się okazja, Big Tech prawie zawsze będzie przedkładać zyski nad ludzi. Dlatego stworzyliśmy własną ścieżkę w przestrzeni AI.

Aby uchwycić istotę AAVE, Huggins przeszkoliła swój algorytm na pismach czarnoskórych autorów z okresu renesansu w Harlemie, czarnoskórych autorów w edukacji, a nawet na mowie jej nastoletniej córki. Huggins współpracuje również z pedagogami, lingwistami i ekspertami ds. kultury, aby przeglądać i weryfikować wyniki Spark Plug. Jej produkt również nie jest oparty na ChatGPT. Jest to własny model, co oznacza, że użytkownicy kontrolują swoje dane.

Pasmore ma również plany zbudowania osobnego modelu podstawowego dla swojego Latimera.AI. Obecnie pracuje nad rozszerzeniem swojej firmy na szkoły, zwłaszcza HBCU, ponieważ coraz więcej uczniów codziennie korzysta z ChatGPT, aby dokończyć swoją pracę.

„To lepszy towarzysz sztucznej inteligencji do wielu prac, które wykonują czarnoskóre i brązowe dzieci” – powiedział.

Zjednoczenie diaspory

Afryka jest postrzegana jako pomijana w obecnym ruchu AI. Na przykład tylko 0,77% wszystkich czasopism poświęconych sztucznej inteligencji na świecie pochodzi z Afryki Subsaharyjskiej, w porównaniu z Azją Wschodnią i Ameryką Północną, gdzie odsetek ten wynosi odpowiednio 47,1% i 11,6%, według badania z 2023 r. Raport dotyczący indeksu sztucznej inteligencji. Pod względem liczby ludności, w porównaniu z Ameryką Północną, Afryka stanowi około 17% światowej populacji, w porównaniu z zaledwie 7% Ameryki Północnej. Kiedy nadchodzi czas, aby pozyskać informacje i ekspertów na temat sztucznej inteligencji, szanse na wykorzystanie badań z krajów Afryki Subsaharyjskiej są dość niskie, co może mieć wpływ na rozwój globalnych narzędzi sztucznej inteligencji.

Chociaż w Afryce nastąpił duży postęp w tworzeniu bardziej włączających modeli językowych, które lepiej służą czarnej diasporze, obecnie obecne modele sztucznej inteligencji, od ChatGPT po Gemini, nie są w stanie w pełni obsługiwać ponad 2000 języków używanych w całej Afryce.

Stworzyła Yinkę Iyinolakan CDIAL.AI aby się tym zająć. CDIAL.AI to chatbot, który mówi i rozumie prawie wszystkie afrykańskie języki i dialekty, ze szczególnym naciskiem na wzorce mowy, a nie na tekst.

Iyinolakan powtórzył w TechCrunch to samo zdanie, które wyraziło wielu czarnoskórych Amerykanów – że podstawowe modele sztucznej inteligencji są pobierane głównie z danych internetowych i z najczęściej używanych języków. Podobnie jak kultura potomstwa Afroamerykanów, wiele afrykańskich języków i tradycji jest nieobecnych w Internecie, ponieważ jest to kultura historycznie przekazywana ustnie, a nie w formie pisemnej. Oznacza to, że modele sztucznej inteligencji nie mają wystarczających informacji na temat kultur afrykańskich, aby się szkolić, co powoduje lukę w wiedzy.

Do współpracy z CDIAL.AI Iyinolakan zaangażował ponad 1200 rodzimych użytkowników języka i lingwistów z całej Afryki, aby zebrali wiedzę i spostrzeżenia w celu zbudowania, jak to określa, „pierwszego na świecie wielojęzycznego modelu dużego języka, w którym najważniejszy jest głos”. W ciągu najbliższych 12 miesięcy firma planuje rozszerzyć swoją działalność o jeszcze więcej języków i zbudować model obsługujący tekst, głosy i obrazy.

Nie jest tu sam. Niedawno firma Google przyznała firmie Jacaranda Health z siedzibą w Kenii dotację w wysokości 1,4 miliona dolarów na rozwój usług uczenia maszynowego, tak aby mogły one działać w większej liczbie języków afrykańskich, a firma Intron Health zebrała niedawno kilka milionów dolarów na skalowanie swojego klinicznego rozpoznawania mowy pod kątem ponad 200 akcentów używanych w całej Afryce .

„Dolina Krzemowa chce wierzyć, że jest to ostateczny cel sztucznej inteligencji” – powiedział Iyinolakan. „Ale aby „pozyskać” sztuczną inteligencję, którą wszystkie firmy uważają za swoją gwiazdę północną, muszą wykorzystać jedną trzecią wiedzy świata”.

Robimy postępy

Wykorzystywanie chatbotów AI nie jest jedyną innowacją, z którą starają się uporać czarni założyciele.

Firmę założyli Steve Jones i DeSean Brown pocstock do tworzenia zdjęć seryjnych osób kolorowych, ponieważ przez dziesięciolecia brakowało mniejszości reprezentowanych na zdjęciach stockowych. Jest to jeden z powodów, dla których dzisiejsze modelki wypluwają głównie zdjęcia białych ludzi, gdy użytkownicy proszą je o wygenerowanie zdjęć wszystkiego, od lekarzy po piosenkarzy popowych.

„Wszystkie platformy i narzędzia powinny być szkolone na podstawie pełnych, włączających rasowo i kulturowo dokładnych danych, w przeciwnym razie (utrwalą) problemy z uprzedzeniami, przed którymi stoi obecnie nasze większe społeczeństwo” – Jones powiedział TechCrunch. Aby rozwiązać ten problem, pocstock przez ostatnie pięć lat zbierał dane dotyczące różnorodności i tworzył własny system tagowania wizualnego, który stanowi wkład w bazę danych wykorzystywaną przez firmy do szkolenia modeli sztucznej inteligencji, dzięki czemu mogą one tworzyć bardziej włączające obrazowanie.

Następują jednak pewne ulepszenia. Jones powiedział, że zauważył, że większe firmy zajmujące się obrazowaniem stockowym, które korzystają z usług firm zajmujących się sztuczną inteligencją, robią większe postępy w zwiększaniu różnorodności swoich treści. Pasmore widzi przed sobą także lepszą przyszłość, twierdząc, że spersonalizowana sztuczna inteligencja i tak jest przyszłością i że im więcej modeli sztucznej inteligencji wchodzi w interakcję z użytkownikami, tym lepiej rozumie pragnienia i potrzeby konkretnej osoby, „co, jak sądzę, eliminuje wiele uprzedzeń .”

W przyszłości może nawet pojawić się miejsce na bardziej specyficzne kulturowo modele sztucznej inteligencji, zwłaszcza że pojawia się coraz więcej alternatyw należących do Czarnych. W końcu świat jest ogromny i pełen niuansów — nie ma sensu umieszczać go w jednej czarnej skrzynce.

„Mam nadzieję, że więcej twórców koloru zaangażuje się w rozwój własnych platform sztucznej inteligencji lub tworzenie nowych stanowisk pracy związanych ze sztuczną inteligencją jak najwcześniej w kolejnym boomie gospodarczym” – powiedział Jones. „Sztuczna inteligencja stworzy bilionerów i bardzo chciałbym, aby ludzie kolorowi zajęli pozycję producentów, a nie tylko konsumentów”.

Technology

One of the long -term VC Elona Muska suits his former employer after alleged dismissal

Josh Raffaella, who has deep roots as an investor of the Silicon Valley and was supported by many firms Elon Musk, suits his former employer, massive trillion dollars Aum Brookfield Asset Management, reports the New York Times.

A major part of Raffaella’s criticism concerns how Brookfield covered losses related to the pandemic of real estate and claims that the company released him after submitting the criticism of informants at SEC. His lawsuit gives allegations akin to fraud and bribe, while Brookfield deny all offenses rapidly, said The Times.

In February, Brookfield quietly closed the Venture Capital unit run by Raffaella and threw some assets on one other unit, Bloomberg reported at the moment. One of Raffaella’s complaints in the lawsuit is that Brookfield didn’t buy so many shares in firms belonging to musk because he provided the possibility of purchase.

Raffaella had shopping transactions in Musk, akin to SpaceX, XAI and a boring company, claims the claim. Bloomberg announced that his Brookfield fund was an awesome supporter of Twitter’s takeover by Musk.

The lawsuit is a really public battle of Raffaella, who previously worked as a partner at VC, known at the time as a drapeer Fisher Jurvetson. (Today it’s a set of funds.) In DFJ Brookfield, it has helped this company spend money on Musk, akin to Solarcity (acquired by Tesla), Spacex and Tesla.

(Tagstranslate) Brookfield

Technology

The AI X Dream Machine library project is intended to help in underestimated innovators

Through the project of the AI X library, the CNN commentator, activist and entrepreneurs Van Jones and co -chairman of the projects Inayah Bashir and Steven Pargett be sure that the Black and Brown communities have free, practical opportunities to learn the force of artificial intelligence.

Libraries have long been secure for knowledge, access and community. Now they grow to be starts in innovation. Through the CNN commentator, the activist and entrepreneur Van Jones and co -chairing Project Inayah Bashir and Steven Pargett be sure that black and brown communities have free, practical possibilities of learning the strength of artificial intelligence.

Launched by the trio Dream Machine Innovation Lab in cooperation with Google, AI X Library Project already has an impact on cities corresponding to Brooklyn and Atlanta, with plans to extend on Miami, Detroit and Los Angeles.

“We don’t just want to consume technology – we want to create, shape and run it,” said Jones during an interview with Black company. „Myślę, że AI jest potencjalnie najbliższe odszkodowania, jakie kiedykolwiek dostaniemy, ponieważ po raz pierwszy od 400 lat mamy dosłownie równy dostęp i równe szanse na coś transformacyjnego. To, o czym polega nasz projekt, jest wrażliwa na możliwość i upewniając się, że jesteśmy w rozmowie o równym dostępie do dobrej rzeczy. Jeśli chodzi o edukację, jeśli chodzi o edukację, jeśli chodzi o edukację, jeśli chodzi o edukację, jeśli chodzi o edukację, jeśli It is about education when it comes to education when it comes to education when it comes to education.

Instead of focusing only on threats of artificial intelligence, corresponding to algorithmic prejudice, Jones, Pargett and Bashir, they challenge themselves to concentrate on the chances. “Often black people are very sensitive to threat and we quickly go into conversations about equal protection against bad things,” said Jones. “This is important. But our project is to be sensitive to possibilities-insulting that we are also in a conversation about equal access to good things.”

Libraries are a perfect entry point for such a democratized technological education. “The library has always been a technology center or anything else,” Bashir noted. “In the case of insufficient or underestimated people, the library is a place where they touch new technology for the first time. When the computers came out, when the internet began, people went to libraries to learn.”

During each AI X library workshop, participants can pick from topics corresponding to marketing with artificial intelligence, writing with AI-Holności, intelligent monitors and the long run of labor. Importantly, local librarians help select which topics might be taught on the idea of the needs of their patrons.

“We were looking for a way to transfer this conversation to real communities,” said Jones. “A lot of online and fancy conferences are happening, but not much at the neighborhood level. Most districts still have a library. This is a trusted place. We decided to go there.”

The project attracted participants on the age of seven and old as 70, creating an intergenerational learning environment. “We develop at least three new business ideas in every workshop,” said Bashir. “In Atlanta we had a mother who runs a collective at home. She said that they already use artificial intelligence to plan the curriculum – and even used artificial intelligence to find our event.”

Other participants are a waste management employee in Miami, bringing their two sons to study next to him, and grandparents examined AI tools for the primary time. “It is amazing that families learn together,” said Bashir. “Excience exists – creativity is there.”

Changing considering, not only skill sets

In contrast to the digital division in the 90s, where access to software and hardware created entry barriers, Jones believes that the most important obstacle with which our communities with which they stand today is the way in which of considering. “We have no problem with the equipment because everyone has a smartphone,” said Jones. “We have no problem with the software because it is so much free now. We have a problem with” wet software “. Our brains do not process artificial intelligence as something that is for black people. It must change. “

Instead of perceiving artificial intelligence as a perfect, almighty tool, Jones encourages people to give it some thought as “a bit stupid, but free, very fast interns”. He explained: “Nothing is perfect – you need to check human work and you need to check the work AI. But do you prefer to improve something that you will get in two weeks or improve something that you will get in two minutes?”

Marlon Avery repeated this sentiment, reminding the participants that everybody is involved with AI for the primary time at their very own pace. “It’s okay to hurry,” Avery said. “AI is like a treadmill – you can walk, jogging or sprint depending on what you are ready for. It is important to get on it.”

Building liberatorial innovations

Ultimately, the project of the AI X library concerns something greater than just learning latest tools – it is concerning the idea of a greater future.

“Liberatorial innovation is not only creating new technologies and new systems – it is about creating new freedoms,” explained Bashir. “Our brains, our communities, even our definitions of what it means to be human.

Jones emphasized the urgency of quite a lot of participation in technology. “When one small group tries to design a civilization for everyone, it doesn’t work well,” he said. “We now have a chance to build something more human, more simply – but only when everyone takes place at the table.”

When Dream Machine tries to scale the project of the AI X library outside its pilot cities, one thing is clear: the long run of innovation is not only happening in the Silicon Valley – it is built in neighborly libraries, one workshop without delay.

Technology

Fastino Trains AI models for cheap graphics games and just collected USD 17.5 million led by Khosl

Technological giants prefer to boast of trillion parameter AI models that require massive and expensive GPU clusters. But Fastino adopts a special approach.

The startup based on Palo Alto claims that he has invented a brand new kind of architecture of the AI model, which is deliberately small and specific to the duty. Fastino says that the models are so small that they’re trained in low GPU class with a worth lower than $ 100,000.

The method attracts attention. Fastino secured $ 17.5 million of seed funds run by Khosl Ventures, famous for the primary Venture, Fastino, Fastino investor, only TechCrunch tells.

This causes complete financing of the startup to almost $ 25 million. He collected $ 7 million in November last yr within the Przedseed round led by VC ARM M12 Microsoft and Insight Partners.

“Our models are faster, more accurate and cost a fraction for training, while exceeding the flagship models in specific tasks,” says Ash Lewis, general director of Fastino and co -founder.

Fastino has built a package of small models that he sells to corporate clients. Each model focuses on a particular task that an organization might have, equivalent to the editors of confidential data or a summary of corporate documents.

Fastino doesn’t reveal early indicators or users yet, but claims that its performance impresses early users. For example, because they’re so small, his models can provide your entire answer in a single token, Lewis told Techcrunch, showing technology, giving an in depth answer immediately in milliseconds.

TechCrunch event

Berkeley, California

|.

June 5

Book now

It’s still a bit too early to search out out if the fastino approach will gather. The AI Enterprise space is crowded, and firms equivalent to Cohere and Databicks also advertise artificial intelligence that leads in some tasks. And manufacturers of SATA models focused on the enterprise, including Antropic and Mistral, also offer small models. It can also be no secret that the long run of generative artificial intelligence for an enterprise might be in smaller, more targeted language models.

Time can say, but Khosli’s early vote of confidence definitely doesn’t hurt. For now, Fastino says that he’s specializing in constructing the most up-to-date AI team. He is directed to scientists from one of the best AI laboratories who usually are not obsessive about the development of the biggest model or beating comparative tests.

“Our employment strategy is very focused on researchers who may have a contradictory thought process in the construction of language models,” says Lewis.

(Tagstotransate) Enterprise

-

Press Release1 year ago

Press Release1 year agoU.S.-Africa Chamber of Commerce Appoints Robert Alexander of 360WiseMedia as Board Director

-

Press Release1 year ago

Press Release1 year agoCEO of 360WiSE Launches Mentorship Program in Overtown Miami FL

-

Business and Finance11 months ago

Business and Finance11 months agoThe Importance of Owning Your Distribution Media Platform

-

Business and Finance1 year ago

Business and Finance1 year ago360Wise Media and McDonald’s NY Tri-State Owner Operators Celebrate Success of “Faces of Black History” Campaign with Over 2 Million Event Visits

-

Ben Crump1 year ago

Ben Crump1 year agoAnother lawsuit accuses Google of bias against Black minority employees

-

Theater1 year ago

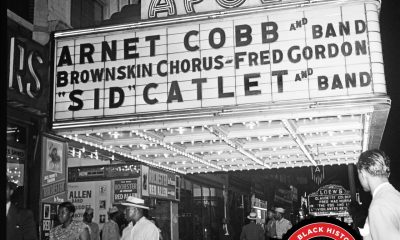

Theater1 year agoTelling the story of the Apollo Theater

-

Ben Crump1 year ago

Ben Crump1 year agoHenrietta Lacks’ family members reach an agreement after her cells undergo advanced medical tests

-

Ben Crump1 year ago

Ben Crump1 year agoThe families of George Floyd and Daunte Wright hold an emotional press conference in Minneapolis

-

Theater1 year ago

Theater1 year agoApplications open for the 2020-2021 Soul Producing National Black Theater residency – Black Theater Matters

-

Theater11 months ago

Theater11 months agoCultural icon Apollo Theater sets new goals on the occasion of its 85th anniversary